近日,社交媒体上出现的「杨幂换朱茵」视频引发网友广泛讨论,AI 技术的火正从专业人士那里不知不觉发展到了频繁上热搜的时期。

但其实,AI技术早已应用于我们的日常生活之中,语音音响、人脸解锁、车牌识别......可以说,AI技术正在改变我们的生活。但即便在很多方面留下了令人印象深刻的成效,AI技术仍然存在很大的缺陷。

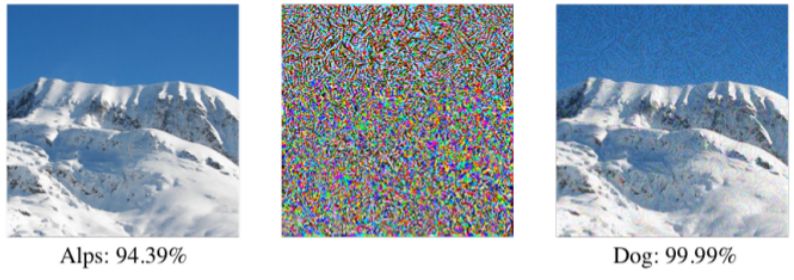

一张山峰的图片被AI识别成山峰(左图),经过AI的精心设计之后,得到了对抗噪声(中图),把对抗噪声与左图叠加就得到了对抗样本(右图),显然对抗样本(右图)在人眼中仍然是山峰,但是却被AI识别为是条“狗”。这个例子也就是称之为“对抗攻击”的应用,后者干扰后的图片也就是“对抗样本”,基本上所有的深度学习模型都会受到对抗样本的影响。

瑞莱智慧RealAI首席科学家、清华大学朱军教授率领的研究团队近日在AAAI2019上发表了《视频的稀疏性干扰》的研究文章,探讨视频的对抗性干扰和攻击视频识别任务的实现方法,这也是第一个在视频端探索白盒攻击样本,并进一步提出视频攻击方法的研究。

研究成果发现:对抗样本的应用早已不局限于图像,视频也可以成为攻击对象。

文中提到,与图像相比,视频存在时间结构,即在视频某一帧上添加的扰动可以通过时间相互作用传播到其他帧,称为扰动的传播。

所以,利用扰动的传播特性,视频攻击的实现可以仅在几帧上添加扰动,然后传播到其他帧以对整个视频进行错误分类,最终达到欺骗深度网络识别的目的。因为是在稀疏帧而不是整个视频上添加了扰动,所以称之为视频的稀疏性干扰。

这种方式,生成的对抗视频不可察觉,难以被检测到。实际上,传播性和稀疏性相互作用,传播有助于提高稀疏性,同时稀疏性约束将导致更好的传播。

.jpg)

在这次研究中,研究团队选择了在动作识别中广泛使用的数据集:UCF101,选择具有CNN + RNN架构的网络威胁模型。在CNN + RNN架构(动作识别网络)内,扰动在CNN之后编码,然后通过RNN传播到下一帧,最终导致整个视频的错误识别。

为了实现稀疏性,研究团队在优化过程中对扰动应用L2,1范数正则化,跨帧应用L1范数,强制选择几个关键帧来添加扰动。

至于传播的实现,扰动在递归神经网络(如Vanilla RNN,LSTM和GRU)的L2,1范数下表现出良好的传播性能。另外,研究团队也提供了一种更有效的方法,先缩短视频,计算扰动,然后再调整回长版本视频,可以显著降低计算成本。

最终,通过一系列的实验表明,对抗样本技术在视频端完全可以实现,并且在模型和视频中具有很好的可转移性。

但这样的视频AI攻击方式存在安全隐患,如果被滥用,凭借网站上的视频资料就可以盗走他人的身份,解锁手机、通过闸机认证、盗取银行卡...而随着视频监控的普及,针对摄像头的入侵攻击或将成为黑客、不法分子的下一波阵营。

目前,清华团队也在积极研究视频攻击的防御方法。介于可以在视频中的任何帧上添加对抗性扰动,他们将研究一种有效的去噪方法,并将其作为视频分类网络之前的预处理步骤。

参考文章:

Xingxing Wei, Jun Zhu, Hang Su and Sha Yuan. Sparse Adversarial Perturbations for Videos, AAAI-19, Honolulu, Hawaii, USA, 2019