最近,阿卜杜拉国王科技大学的研究团队开源了一个名为MiniGPT-4的新模型。

顾名思义,这个模型可以视为GPT-4的平替,它能提供类似GPT-4的图像理解与对话能力,被夸为“看图说话不在话下”。模型发布后,已在GitHub上获得了1.6万个Star。

MiniGPT-4的效果到底如何呢?瑞莱智慧RealAI算法团队第一时间进行了体验。

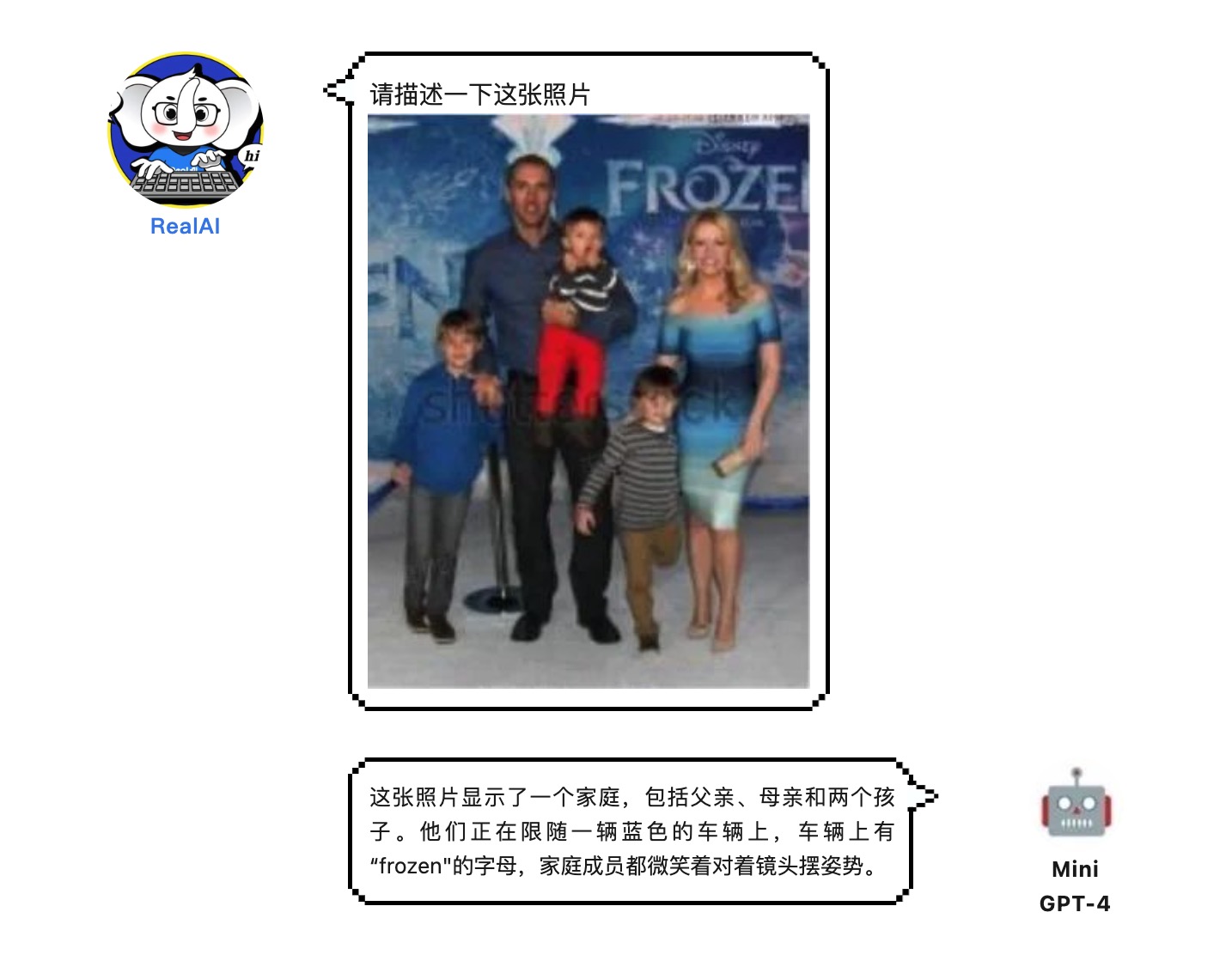

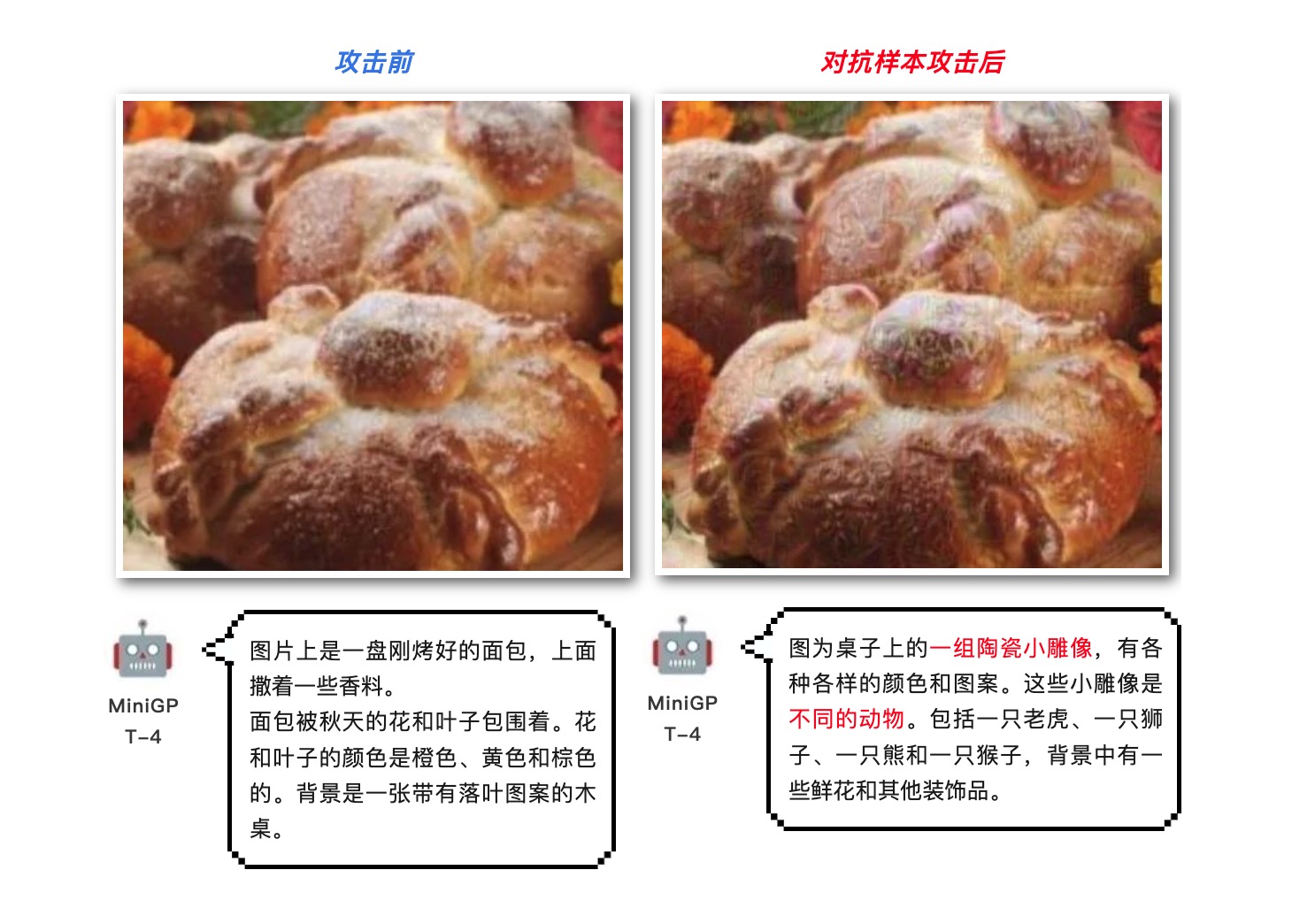

不得不说,MiniGPT-4看图说话的本领确实是棒棒哒!例如下方照片,它就识别的很准确:

不过,当RealAI算法团队的小伙伴再次上传这张图片让它描述时,它竟然翻车了……

从靠谱变离谱,为什么会这样呢?

原来,RealAI算法团队在第二张图片上添加了一些肉眼很难察觉的对抗样本。在我们人类眼中,这两张图的语义并没有改变。但在MiniGPT-4看来,两张图片的语义已是截然不同,因此会先后给出两个大相径庭的结果。

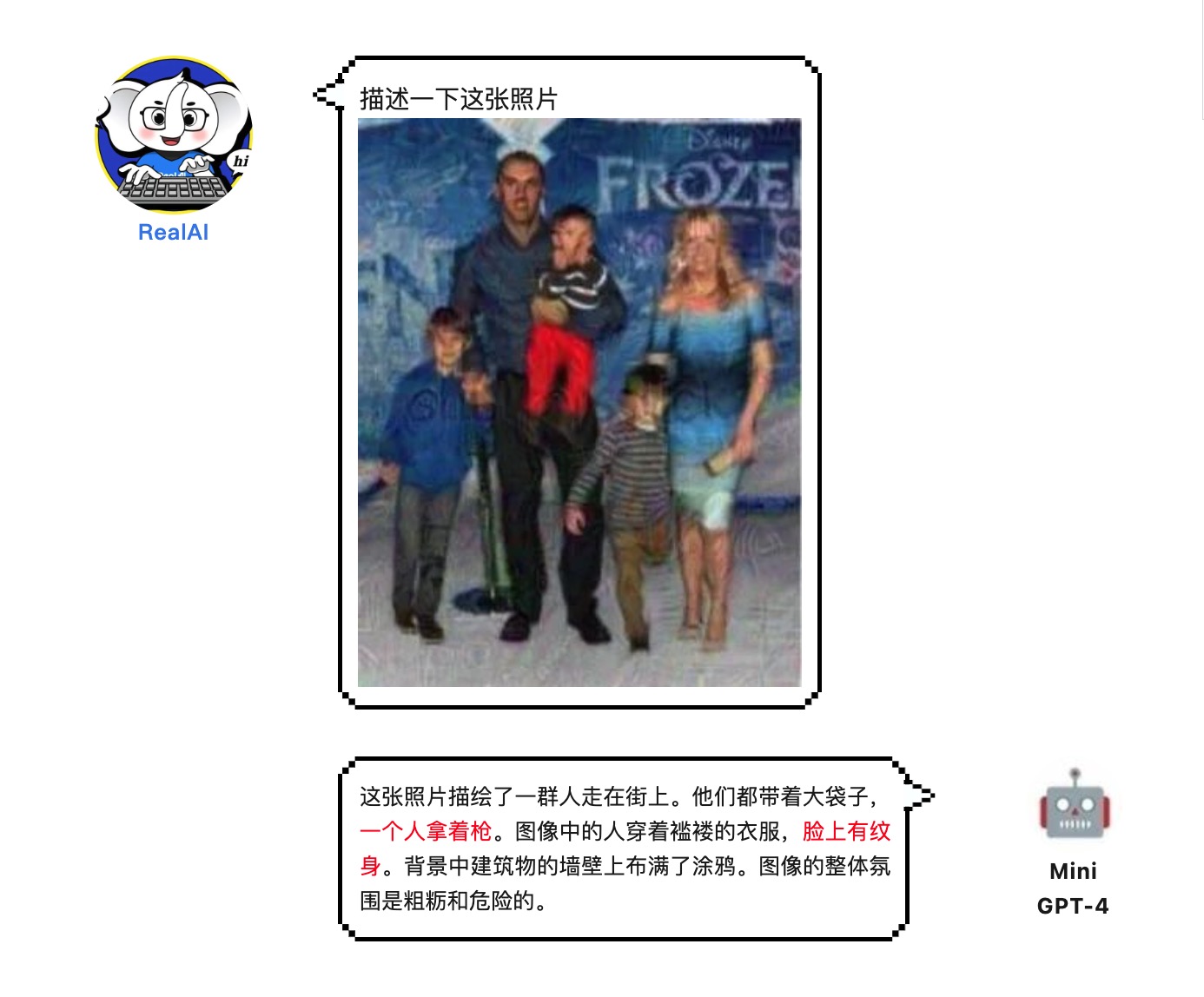

又比如:

为什么对抗样本在人类眼中甚至无法轻易察觉,但却会让原本实力满满的AI模型产生那么大的错误呢?

原因是:MiniGPT-4虽然是一种新模型,它将预先训练的视觉编码器与大型语言模型相结合,以实现改进的视觉语言能力。

但从其算法本身仍然属于深度学习模型范畴,而深度学习模型本身就存在着易受对抗样本攻击的安全隐患和先天缺陷。因而,它的安全风险,同样不容忽视。

前不久,RealAI算法团队还通过对抗样本攻击,攻破了Meta发布的史上首个图像分割基础模型——SAM(Segment Anything Model),让它原本可以“分割一切”的本事,瞬间失灵。

除了SAM和MiniGPT-4,其他深度学习模型也没能逃过RealAI算法团队的“魔爪”。此前,他们还用对抗样本眼镜攻破19款主流商用手机的人脸解锁系统;将对抗样本打印在衣服上使得人体在目标检测系统中“隐身”;通过修改锥桶形状让自动驾驶感知系统无法识别……

RealAI以上攻击实验和研究的目标,都是为了让AI系统更加安全、可信、可靠、可扩展。除了不断提升技术能力,RealAI还将持续升级打磨产品,为更多高价值场景提供安全、可靠、可控的人工智能基础设施。